Las máquinas no saben decidir

Los algoritmos que gobiernan la inteligencia artificial y los robots deben someterse a reglas éticas y morales

BarcelonaLas máquinas, aunque pueda costar de creer, están sometidas a principios morales y éticos. Y, cuanto más sofisticadas sean, lo que implica más grados de libertad y más autonomía, más elevado es el componente ético. Es el caso de robots y también de la inteligencia artificial. En buena medida, que se respeten estos principios depende de su programación, es decir, de los algoritmos que se crean para que las máquinas hagan la función para la que están diseñadas. Dicho de otro modo, de la intervención humana en su concepción. El estudio de estas normas y principios éticos, que va mucho más allá de lo que Isaac Asimov definía en 1950 como que de ninguna manera un robot podía hacer daño a un humano, recibe el nombre de roboética. Una disciplina que crece cada día que pasa y que tiene en la programación del algoritmo su punto central.

Decidir en caso de conflicto

Ramón López de Mántaras, profesor de investigación en el CSIC y ex director del pionero Instituto de Investigación en Inteligencia Artificial (IIIA), es uno de los investigadores que más han reflexionado sobre este tema en nuestro país. "¿Cómo enseñamos a un coche autónomo si hay que girar hacia la derecha o hacia la izquierda en caso de conflicto?", pregunta de entrada. Para el experto, este tipo de vehículos no son otra cosa que "robots con ruedas" gobernados con inteligencia artificial. "Les podemos enseñar a respetar las normas de tráfico, pero no está claro que sepan responder adecuadamente a un incidente imprevisto". Por ejemplo, ante un gran charco de agua, en el que los humanos frenaríamos de manera intuitiva, o las alternativas ante un choque inminente. "¿Atropella a un animal o esquiva a otro coche? ¿Y si es una persona?", dice. Y añade: "Si no conduces ni tienes la posibilidad de hacerlo, ¿quién se hace responsable?"

Este es uno de los muchos dilemas técnicos con carga ética que deben resolver a menudo los programadores de algoritmos. Hay otros igual o más sangrantes. Uno de los más relevantes tiene que ver con el sesgo. "El programador vive en un contexto, una cultura o unas circunstancias concretas", resume López de Mántaras. Por lo tanto, es posible que introduzca valores que no son universales. Podría ser el caso de parámetros con sesgo racista, de género o basados en prejuicios sociales. El resultado de esta programación incluirá el sesgo. "La culpa no será de la máquina ni del algoritmo, sino del programador -dice-. Algunos programas supuestamente avanzados etiquetan como gorilas a personas de origen africano".

El problema se agrava cuando el algoritmo es el encargado de hacer una selección de personal, predecir una condena o revisar una pena, como ya está pasado en diferentes países. O en la elección de trabajadores despedidos de una gran empresa o, mucho más grave, si es el responsable de determinar el objetivo de armas letales autónomas, como lo son los drones de uso militar.

¿Robots? Con cuerpo, por favor

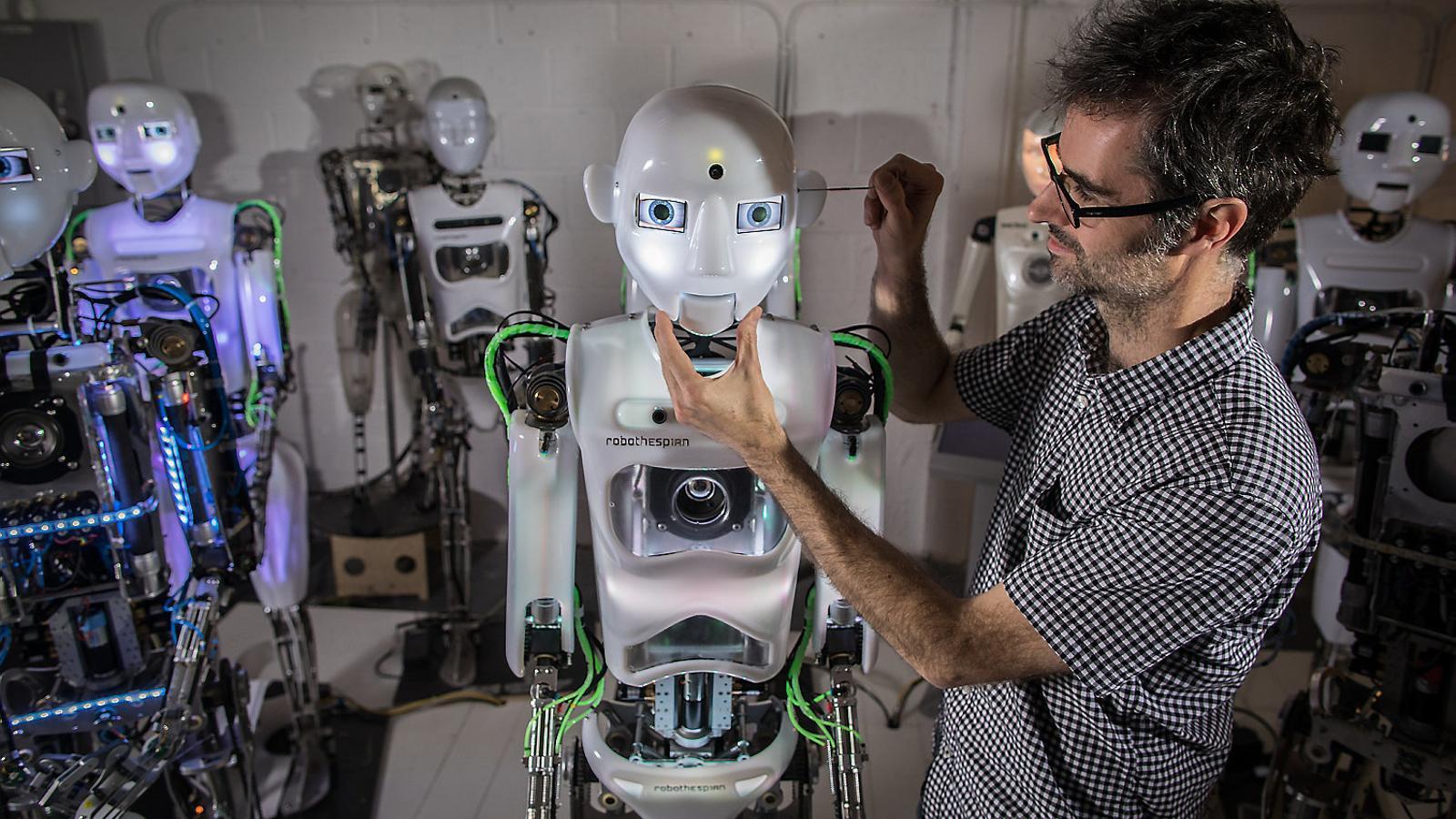

Estos artilugios informáticos y muchos otros programados con inteligencia artificial se tienden a llamar robots. En esencia, porque están automatizados, disponen de un cierto grado de autonomía y tienen la capacidad de mejorar sus prestaciones a medida que adquieren conocimientos. Pero no todos están de acuerdo. Paul Verschure, profesor ICREA en el Instituto de Bioingeniería de Catalunya (IBEC), razona que se puede entender esta denominación como metáfora, pero no como una realidad. "Un robot precisa de un cuerpo, sea cual sea su forma y sean cuales sean los algoritmos que gobiernan su funcionalidad", dice. Esta forma puede ser humanoide o, al contrario, no tener nada que ver, como ocurre con la mayoría de robots industriales. Que tenga forma humana tiene mucho que ver, según Verschure, con una capacidad tan esencial como la comunicación. "En determinadas circunstancias, también en las asistenciales, la forma y los movimientos humanoides facilitan la interacción entre los humanos y las máquinas", dice. Cree que este aspecto puede ayudar a establecer relaciones de confianza, especialmente en pacientes de edad avanzada o con deficiencias cognitivas. Pero el debate ético está abierto. Hay quien considera que este punto puede generar sentimientos de adicción o de sustitución. Obviamente, los algoritmos deben tener presente esta limitación.

Sea como sea, y a pesar de que tendemos a pensar en los robots como herramientas que realizan tareas repetitivas y complejas, peligrosas o de carácter asistencial, y que tienen como primer principio no dañar a los humanos, la realidad es que todavía estamos muy lejos, dice Verschure, de que sean una realidad fehaciente. Probablemente, dice López de Mántaras, se ha avanzado más en la generación de algoritmos que en la capacidad de dotar de autonomía a los robots. "Salvo los que trabajan en el entorno de la automoción o empresas con necesidades similares, el resto son muy poco eficientes y su gasto energético es altísimo", dice el experto del IBEC. "Pensar en robots sofisticados y altamente autónomos es todavía ciencia ficción", añade. Una fantasía mecánica pero una realidad más cercana en términos de inteligencia artificial y generación de algoritmos que ayudan en la toma de decisiones y que se tiene tendencia a hacerlos decidir por nosotros. Pero como dice López de Mántaras, "las máquinas no saben decidir". Por eso se necesitan regulaciones legales y èticas.